Każdy kto używa Google Analytics na swojej witrynie na pewno zauważył błędne zliczanie wejść. Błędne tzn. zawyżone przez boty. Często w kanale Referral widać również dziwne adresy, z których rzekomo ktoś wszedł na naszą stronę. Jest jeden prosty sposób jak się tego (chociaż częściowo) pozbyć.

Do najbardziej uciążliwych referrali należą:

- free-share-buttons.com (oraz wszystkie subdomeny)

- best-seo-offer.com

- sanjosestartups.com

- www.event-tracking.com

- offers.bycontext.com

- guardlink.org

- buttons-for-your-website.com

- ilovevitaly.com

- непереводимая.рф

- www.Get-Free-Traffic-Now.com

- free-social-buttons.com (oraz wszystkie subdomeny)

- searches.uninstallmaster.com

Pozbądź się ich jednym kliknięciem

Wszelkie poradniki dotyczące tego problemu polecają tworzyć filtry w Analytics albo co gorsza nowe reguły w naszym .htaccess. Minusy tego rozwiązania są oczywiste:

- Możemy przez przypadek zablokować dobry ruch

- Lista referrali cały czas się będzie zmieniać

- Każda zmiana będzie musiała być naniesiona w filtrze/.htaccess

Ale już jakiś czas temu (30 lipca 2014) samo Google zaproponowało rozwiązanie. Możemy wyłączyć wszystkie działania robotów jednym kliknięciem.

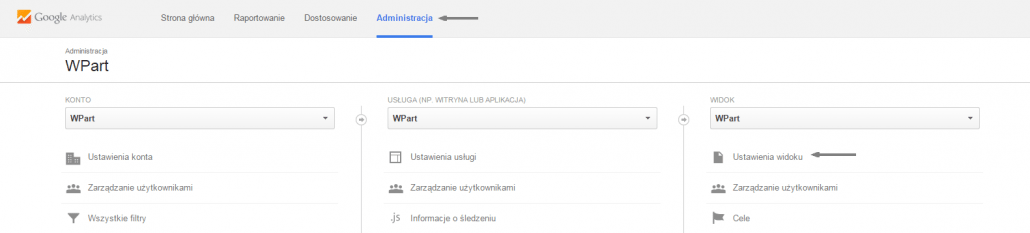

Aby to zrobić należy wejść w Analytics w zakładkę Administracja i przejść do Ustawień widoku:

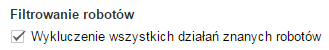

i zaznaczyć checkbox:

Uwaga: metoda może filtrować nie wszystkie spamowe odniesienia, warto jednak spróbować.

Wiesz, że to nie działa? Takie ustawienie mam od „zawsze” – wyklucz znanych robotów nie działa, bo nie w robotach problem. Problem jest w niezabezpieczonym API, więc żaden robot na stronę nie wchodzi, tylko wysyła zapytania do serwerów Google. Jeśli masz na stronie inne systemy typu analytics, to w żadnym innym nie dostrzeżesz takich zapytań. Google nie chce się ruszyć tyłka i załatać możliwość spamowania systemu.

W sensie wysyła event z własnej witryny z podmienionym UA-* i adresem ustawionym na 'auto’ ?

Prawdopodobnie to własnie robi, ponieważ UA-* to tylko ciąg liczb, więc może sobie nawet losowo to robić. A po co to robi? Też wiadomo – każdy kto wejdzie na taki adres zostaje przekierowany na stronę partnerską i ustawia odpowiedni cookie. Dzięki temu on od każdego zakupu, który ktoś zrobi z takim ciasteczkiem, dostaje prowizję. Dlatego adresy ciągle się zmieniają, ale docelowo trafiasz w to samo miejsce. Właściwie gdy sam szukałem sobie rozwiązania, to znalazłem instrukcję jak sobie takie wywołanie do API zrobić…

No dobra, ale rozwiązanie… są trzy. Jedno – blokujemy wszystko i bawimy się filtrami. Drugie, też bawimy się filtrami, ale ustawiamy, żeby przyjmować ruch tylko z naszych witryn, co w praktyce sprowadza się do naszej strony i ewentualnie YouTube i tym podobnych. Trzecie – zmiana konta, aby nasz UA-* kończył się na inną końcówkę, bo większość tych numerów ma formę UA-xxxxxxxx-1, a po wymianie może przybrać formę UA-xxxxxxxx-2 – tylko, że wtedy startujemy ze statystykami od nowa, bo nie ma importu, ale spamu też nie powinno być. Ale co ja tam wiem o blogowaniu…

Cholera, dwie pierwsze to dużo roboty, a trzecia wydaje się też mało skuteczna – nie problem przecież wygenerować jakąkolwiek kombinację z suffixami.

Pierwsza metoda – na pewno nie kończąca się. Druga metoda wg tego co czytałem, to tylko raz. Trzecia metoda jest skuteczna na razie, bo prawie wszyscy mają na końcu domyślnie 1.

Nie znam technikaliów, ale potwierdzam sam fakt. Filtrowanie robotów w widoku GA mam ustawione „od nowości”, a spamu tylko przybywa. W Clicky nie ma tego problemu.

P.S. Gratulacje za tytuł wpisu. Nie mogłem nie kliknąć :)

Dzięki :)

Niestety, ta funkcja wyklucza tylko roboty z listy IAB (https://plus.google.com/+GoogleAnalytics/posts/2tJ79CkfnZk), a ona (z tego, co się orientuję) zawiera wszelkiej maści boty indeksujące itp., ale nie zawiera domen, które generują referrer spam. Obawiam się, że jedyną skuteczną metodą jest ręczne definiowanie filtrów w GA, na przykład na podstawie listy spamujących domen od Piwika (https://github.com/piwik/referrer-spam-blacklist/blob/master/spammers.txt).

O, dzięki za konkrety!

Hm, większość podanych serwisów chyba z Rosji. Atakują ze wszystkich stron.

Można blokować ich przez .htaccess

Z .htaccess łatwo zablokować normalny ruch i tak jak ustaliliśmy wcześniej, te roboty nawet nie wchodzą na stronę tylko wywołują tracking u siebie

Dzięki za ten wpis, bo już godziny spędziłem na tym, gdzie też na aliexpress jest link do mojej strony….